- 软件介绍

- 软件信息

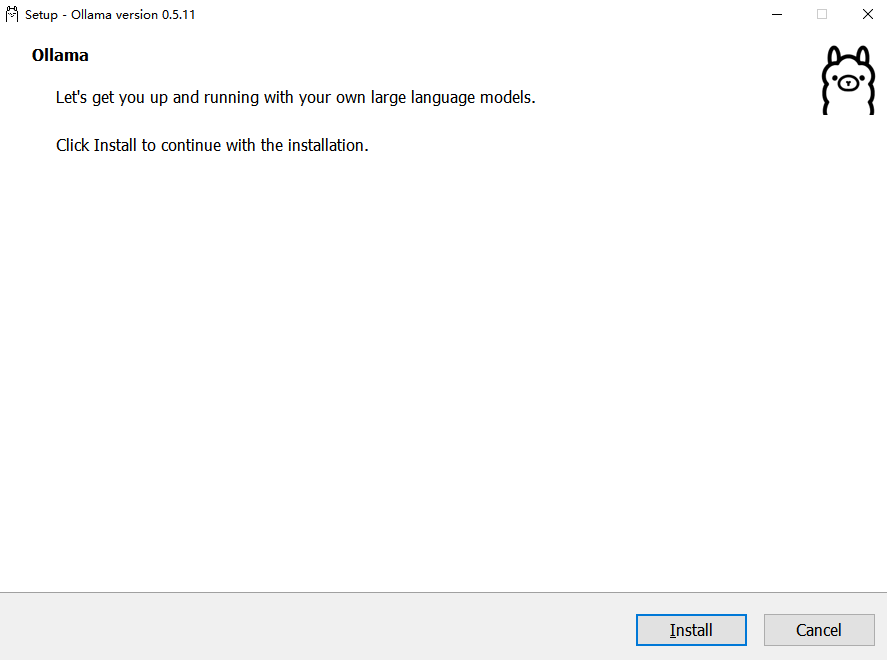

- 软件截图

- 相关下载

- 下载地址

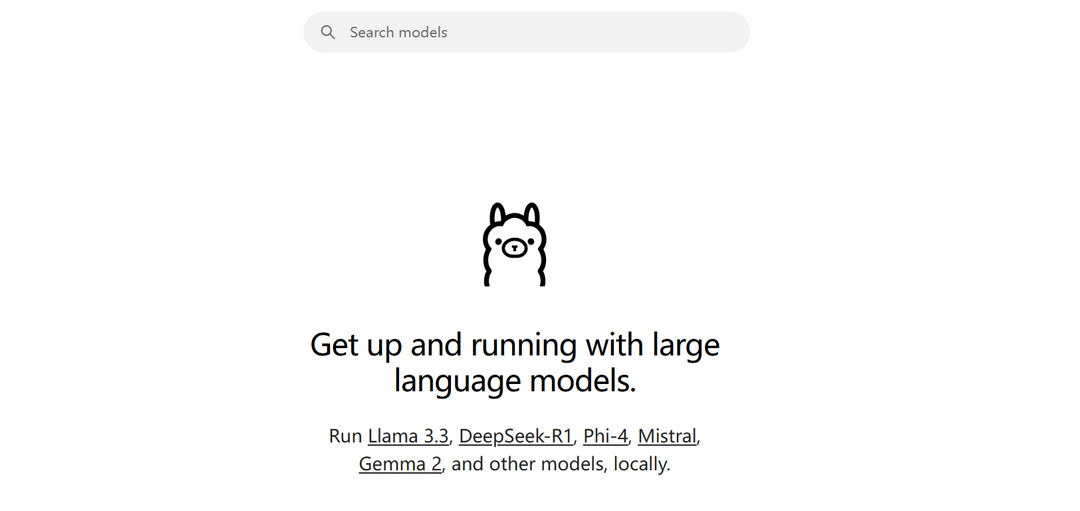

Ollama是一款本地AI开发与部署平台软件,旨在简化AI模型的使用和管理流程,通过强大的本地运行能力、丰富的模型支持以及简洁的用户界面,Ollama 让用户能够在本地设备上轻松运行、测试和部署AI模型,无需依赖复杂的云服务或高昂的硬件成本。

Ollama软件功能

1、本地运行与管理

Ollama 支持在本地设备上运行AI模型,无需依赖外部云服务,确保数据隐私和安全性。

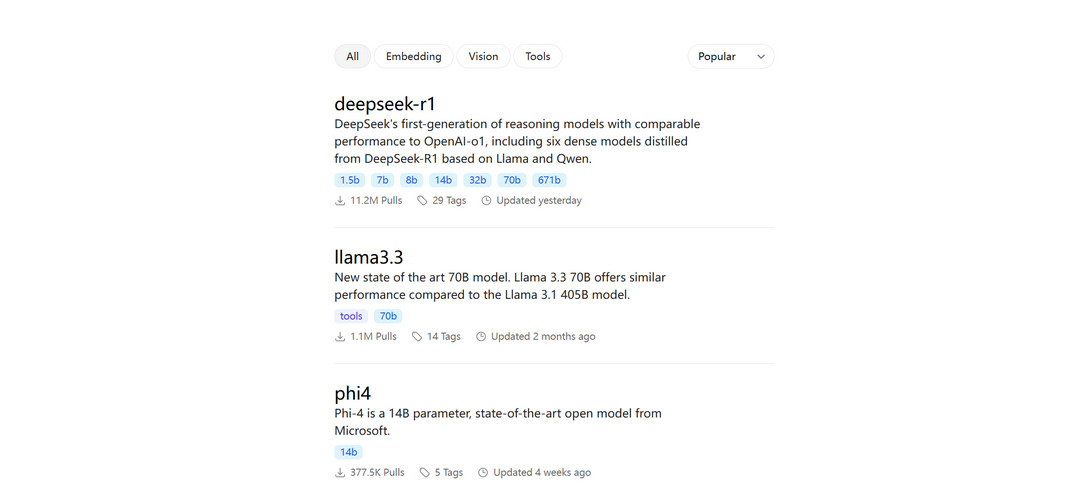

2、丰富的模型库

内置多种流行的AI模型,如 Llama、Alpaca、Vicuna 等,用户可以根据需求快速切换和使用。

3、一键部署

通过简单的命令或界面操作,用户可以快速部署AI模型,无需复杂的配置和代码编写。

4、多平台支持

兼容 Windows、macOS 和 Linux 等主流操作系统,用户可以在不同设备上无缝切换。

5、实时交互

支持与模型的实时交互,用户可以通过命令行或图形界面直接与模型对话,快速测试和验证模型效果。

6、模型优化与定制

提供模型优化工具,帮助用户根据具体需求调整模型参数,提升性能和效率。

Ollama软件亮点

1、简洁易用的界面

提供直观的图形界面和简洁的命令行工具,无论是新手还是资深开发者都能快速上手。

2、数据隐私保护

所有数据处理均在本地完成,确保用户数据的隐私和安全,避免数据泄露风险。

3、快速启动与响应

优化的本地运行环境,确保模型快速启动和高效响应,提升开发效率。

4、社区支持与扩展

活跃的开发者社区,提供丰富的教程、插件和扩展支持,帮助用户更好地使用和定制 Ollama。

5、资源高效利用

智能资源管理,根据设备性能自动优化模型运行,确保在有限的硬件资源下也能高效运行。

安装步骤指南

1、在本站下载Ollama安装包。

2、双击安装包,按照提示完成安装。

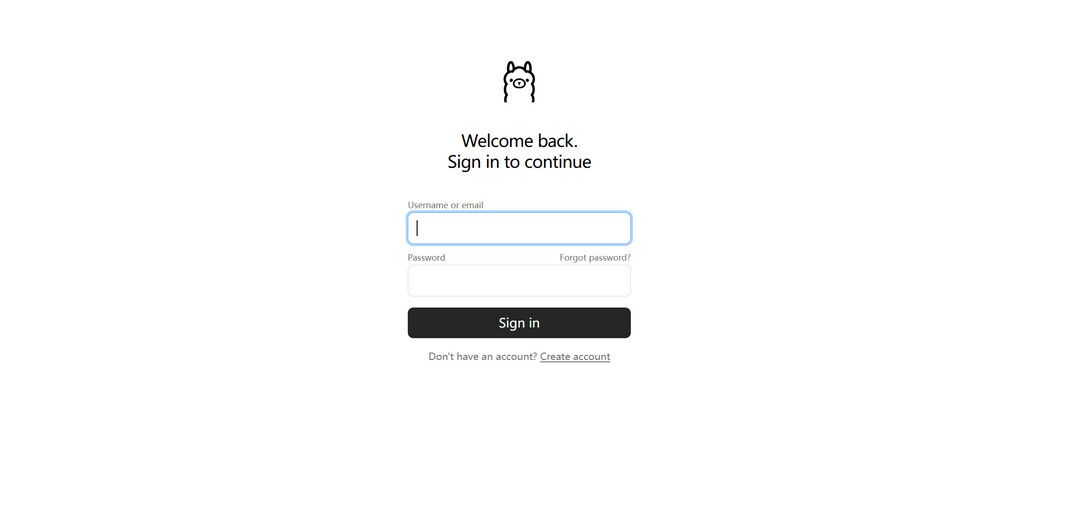

3、安装完成后,打开软件并根据提示进行初始化设置。

4、登录或注册账号后,即可开始使用 Ollama 运行和管理AI模型。

常见问题解答

Q1:Ollama 是否支持自定义模型?

A:是的,Ollama 支持用户上传和使用自定义模型,用户可以通过界面或命令行工具导入本地模型文件,并进行优化和部署。

Q2:如何确保数据隐私和安全?

A:Ollama 的所有数据处理均在本地设备上完成,不会上传到云端,此外,用户可以通过加密功能进一步保护数据隐私。

Q3:运行 Ollama 是否需要高性能硬件?

A:Ollama 优化了本地运行环境,即使是普通的笔记本电脑也能运行大多数模型,不过,对于更复杂的模型,建议使用性能较高的设备以获得更好的体验。

Q4:如何更新 Ollama?

A:Ollama 提供自动更新功能,软件会在后台自动检测更新,用户也可以手动进入设置页面,点击“检查更新”按钮进行更新。

Q5:如何获取技术支持?

A:如果在使用过程中遇到问题,用户可以通过 Ollama 官方社区、论坛或客服获取技术支持,此外,Ollama 的开发者社区也提供了丰富的教程和文档,帮助用户解决问题。

软件信息

下载地址

- 本地下载通道:

- 本地下载